身為每天泡在命令列的開發者,terminal 如果長得像 90 年代駭客電影道具,其實也說得過去;但既然現在都有 AI 幫寫 code 了,終端機不升級一下,好像有點對不起自己。這篇就來聊聊怎麼用 GitHub Copilot CLI 加上 Windows Terminal 的客製化,把你的 terminal 從工具升級成工作室。

GitHub Copilot CLI 是什麼?

-

GitHub Copilot CLI 就是把 Copilot 搬進 terminal 裡,讓你不用開 IDE 也能在命令列裡問問題、要指令、請它幫你搞定各種工作。

-

作者分享會在陌生語言或新專案裡,用它幫忙「怎麼 build」、「怎麼下某個 shell 指令」,甚至讓它生成一個超大 lorem ipsum 檔來當 demo 測試檔案,省下一堆時間。

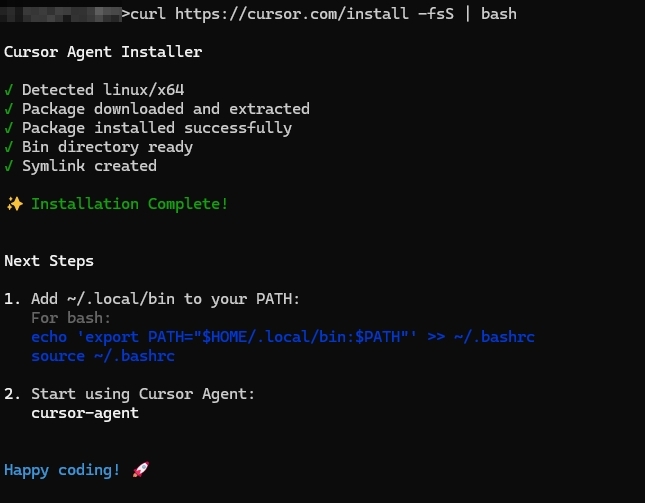

安裝其實很簡單,只要一行 npm:

npm install -g @github/copilot

之後在 terminal 打 copilot 就能啟動 CLI,把它當成會寫文件、會記指令、偶爾還會幫你作弊查指令的搭檔就對了。

先把 Copilot CLI 用爽:Banner、指令與互動

每次啟動都看到那個帥氣 Banner

預設 Copilot CLI 的動畫 banner 只有第一次出現,但作者表示:這麼帥的東西當然要每次看。

有兩個做法:

-

到

C:\Users\USERNAME\.copilot\config.json(WSL 則是~\.copilot\config.json),把"banner"設成"always"。 -

啟動時改下指令:

copilot --banner。

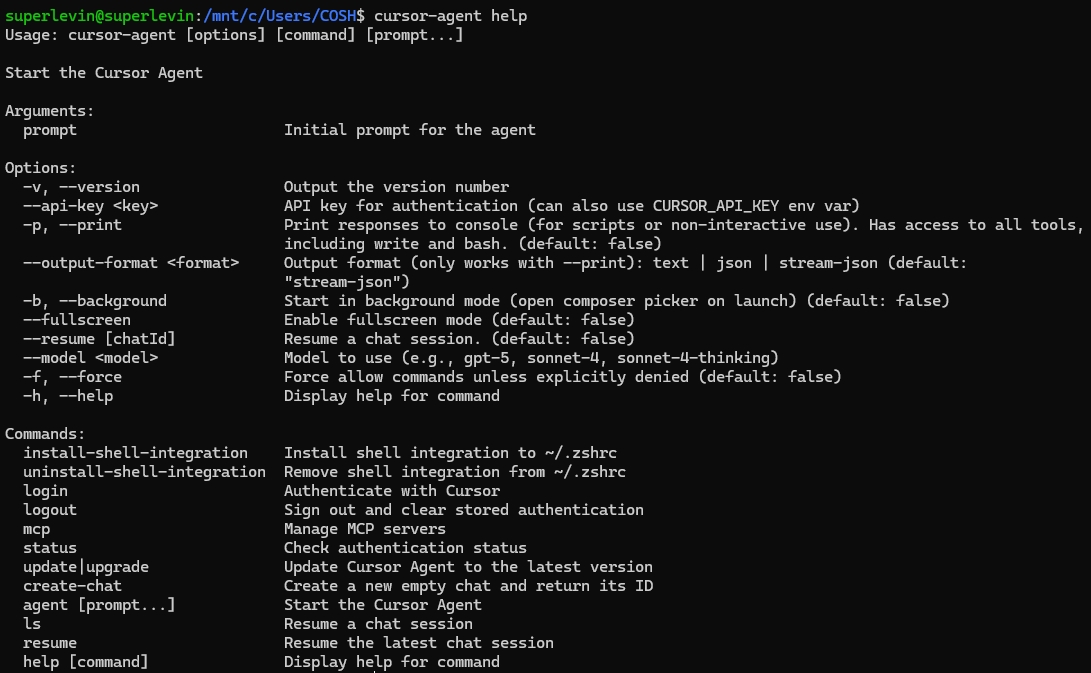

在 Copilot CLI 裡直接跑 shell 指令

進到 Copilot CLI 之後,你輸入的每一行其實都是在跟 agent 聊天。那如果只是想跑個命令怎麼辦?

答案是:指令前面加一個驚嘆號 !。

-

例如:

!git status、!ls,就會直接在 Copilot CLI 裡跑 shell command。 -

好處是不用頻繁切來切去,可以一邊問 Copilot「我要怎麼做」,一邊直接執行它建議的指令。

把 Windows Terminal 變成 Copilot 專屬套房

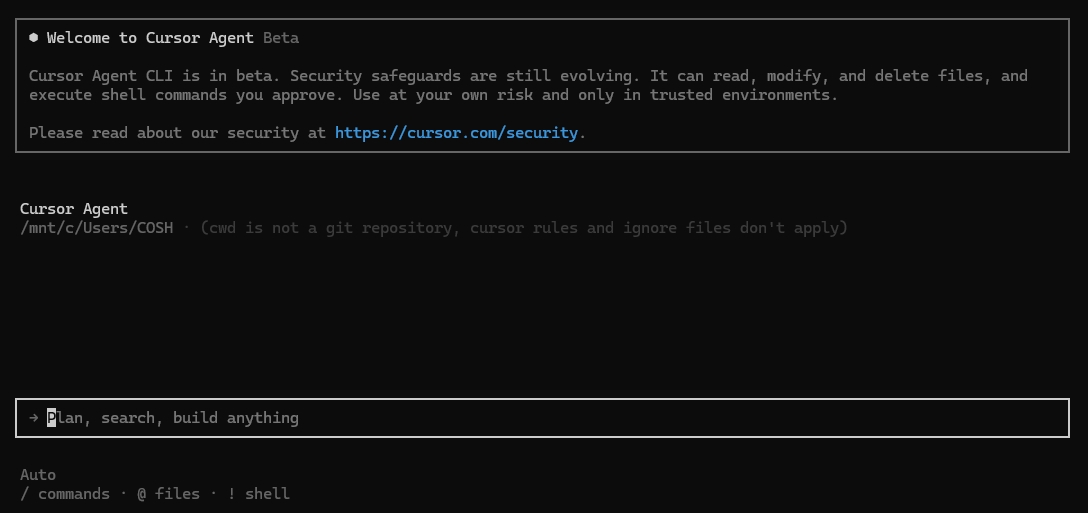

建一個「GitHub Copilot 專用 Profile」

作者的做法很簡單粗暴又實用:

-

複製現有的 PowerShell profile。

-

改名字跟 icon(例如叫「GitHub Copilot」)。

-

Starting directory 設成你平常放專案的資料夾。

-

Command line 後面加上

-c copilot,例如:text"C:\Program Files\PowerShell\7\pwsh.exe" -c copilot

這樣一開這個 profile,就自動進入 Copilot CLI,不用再多打一行指令。

用 pane 分割:一半 Copilot,一半 shell

如果你想一邊跟 Copilot 聊天,一邊在另一個 shell 動手做,可以善用 Windows Terminal 的 pane 功能:

-

按住

Alt再從 profile 下拉選單開啟新 profile,就會以分割 pane 方式打開。 -

要關掉 pane 的話,用

Ctrl + Shift + W即可。

對多 repo、microservices、或 dev/test 併行的人來說,pane 基本上就是多工的救星。

啟動就回到上一次的工作現場

開發時最痛苦的就是「重開一次,原本開了哪些 tab 都不見」;作者直接把 Windows Terminal 的 Startup 設定改成「Restore window layout and content」,讓 Terminal 重啟時自動還原上次 tab 佈局。

對正在 debug 或 demo 的人來說,這個設定等於幫你省下一輪「再把環境全部打開一次」的懲罰。

背景圖 + 復古掃描線特效

-

Windows Terminal 支援每個 profile 設不同背景圖,也可以在 Defaults → Appearance 當中設一張所有 profile 共用的背景圖。

-

想要懷舊一點,可以開啟「Retro terminal effects」,讓文字帶一點發光跟掃描線效果,兼具情懷與中二感。

Prompt 也要穿得體面:Oh My Posh 上場

光只有 Copilot 不夠,terminal prompt 本身也要有點「生活品質」:這時候就輪到 Oh My Posh。

裝好 Oh My Posh + Nerd Font

-

安裝 Oh My Posh(作者偏好用

winget):bashwinget install JanDeDobbeleer.OhMyPosh --source winget

```[1]

-

接著下載一套 Nerd Font,作者愛用 Caskaydia Cove,你也可以選自己喜歡的字型,再到 Terminal 裡把該字型設定成 profile 的字型。

選一個主題,變成你的個人看板

-

官方主題列表在 Oh My Posh 官網,挑一個順眼的主題後,在 PowerShell profile 裡加上像下面這樣的一行:

powershelloh-my-posh init pwsh --config "THEMENAME" | Invoke-Expression

之後每次開 PowerShell 都會套用這個主題。

-

作者自己還貢獻了一個叫「cinnamon」的主題,可以把現在 Spotify 播放的歌顯示在 prompt 上,對邊聽音樂邊寫 code 的人非常友善。

用 segment 把資訊塞進一行 prompt

Oh My Posh 的強項在於各種 segment,像是:

-

Git segment:直接在 prompt 顯示目前 branch、diff 狀態、是否有未提交變更等。

-

npm、React segment:顯示目前使用的 npm 或 React 版本。

-

音樂、甚至健康狀態 segment 都有,terminal 直接變成迷你 dashboard。

在 prompt 上看 Copilot 使用量:Copilot segment

如果你是 Copilot 重度用戶,可能會好奇自己 quota 用了多少。從 Oh My Posh 28.1.0 之後,可以新增 GitHub Copilot segment,在 prompt 上顯示 Copilot premium 配額使用百分比。

作法大致是:

-

從官方主題(例如

1_shell)複製一份 JSON 當自訂主題。 -

在右側對齊的 segments 列表中加入一個像這樣的物件:

json{

"type": "copilot",

"template": " {{ .Premium.Percent.Gauge }} ",

"cache": {

"duration": "5m",

"strategy": "session"

},

"properties": {

"http_timeout": 1000

}

}

```[1]

-

在 PowerShell 裡跑一次

oh-my-posh auth copilot做認證,之後 prompt 上就會出現一個小小的 Copilot 使用量 gauge。

這樣你就可以一邊寫 code,一邊默默觀察自己今天「抄作業」抄了多少。

收尾:讓命令列變成你的開發主場

整篇下來,可以看到作者的核心理念很簡單:

-

Copilot CLI 讓你在 terminal 裡有一個隨叫隨到的 AI 搭檔。

-

Windows Terminal 的 profile、pane、背景與啟動設定,讓你把工作流變成一鍵啟動。

-

Oh My Posh 則把 prompt 升級成資訊看板,再加上 Copilot segment,命令列不只是黑框白字,而是你的開發 cockpit。

如果你每天都會開 terminal,那這些設定多花的那幾分鐘,很可能會在未來幾個月裡幫你省下好幾小時的來回切換和查指令時間。下次打開 Windows Terminal,不妨就從幫 Copilot 開一個專屬 profile 開始。