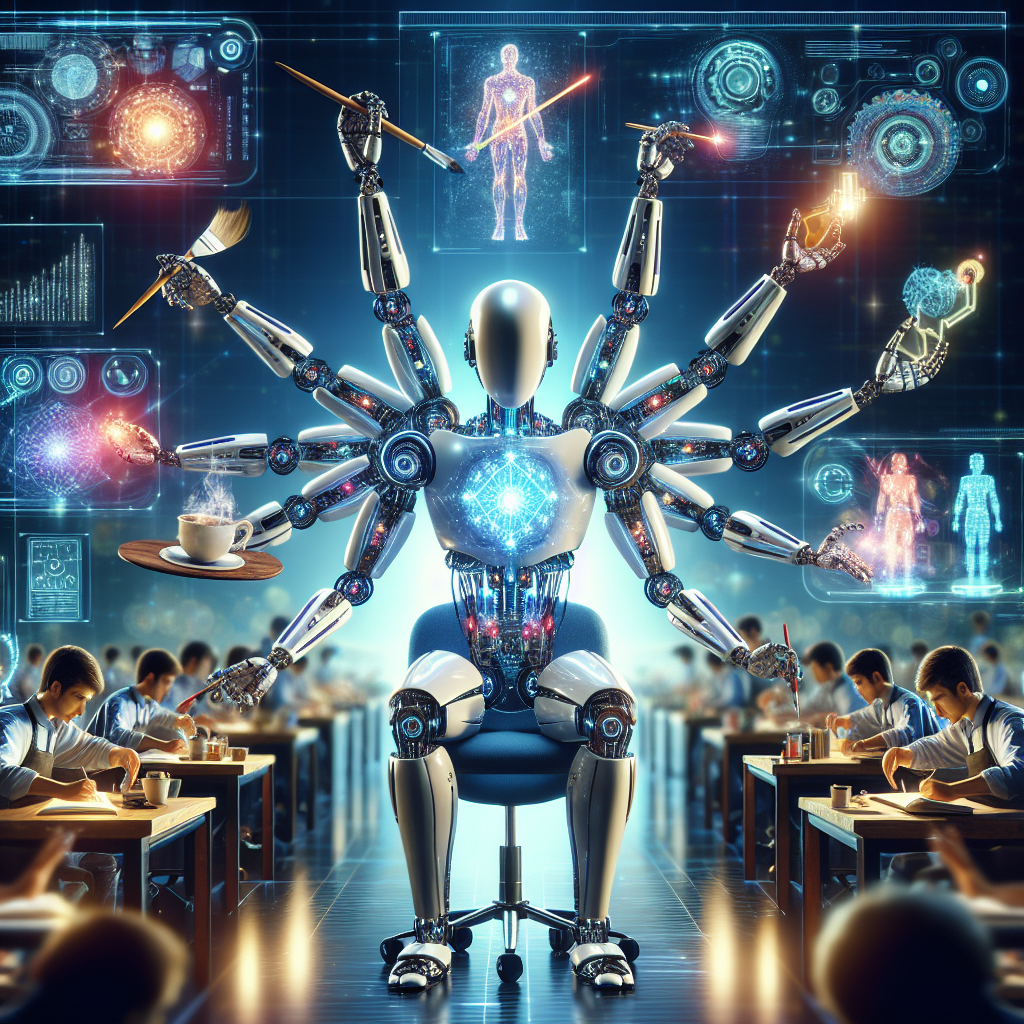

隨著人工智慧技術的快速發展,視訊理解模型正變得越來越重要。Hugging Face 推出的 SmolVLM2 系列,憑藉其高效能與小型化設計,為視訊理解樹立了新標杆。本文將帶你快速了解 SmolVLM2 的核心技術、應用場景及其在視訊理解領域的突破。

SmolVLM2 的願景與目標

SmolVLM2 的使命是將視訊理解的能力帶到每一台設備,無論是手機還是伺服器。與傳統需要大量計算資源的大型模型不同,SmolVLM2 將高效模型與小型化設計結合,實現了低資源環境下的高效視訊處理。

目前,SmolVLM2 提供三種不同規模的模型:

- 2.2B 模型:專為高效視訊和圖像理解而設計,是整個系列的旗艦。

- 500M 模型:在小型化與效能之間取得良好平衡。

- 256M 模型:實驗性質的極小型模型,探索小型模型的極限。

這些模型均可通過 Python 和 Swift API 使用,並且支持 Hugging Face 的 Transformers 框架。

核心技術與性能

SmolVLM2 2.2B:視覺與視訊的領先模型

2.2B 模型在多項基準測試中表現卓越,特別是在 Video-MME 基準上超越了所有現有的 2B 模型。該模型能夠:

- 解決圖像中的數學問題。

- 讀取照片中的文字。

- 理解複雜圖表及科學視覺問題。

其記憶體效率極高,甚至可以在免費的 Google Colab 環境中運行。

更小巧的 500M 和 256M 模型

- 500M 模型 提供了接近 2.2B 的視訊理解能力,但參數量僅為後者的四分之一。

- 256M 模型 則是一個實驗性版本,旨在探索小型模型的應用潛力,適合創新應用和專門的微調項目。

應用場景:SmolVLM2 的多功能演示套件

為了展示 SmolVLM2 的多樣化應用,Hugging Face 開發了多個演示應用程式:

1. iPhone 影片理解

SmolVLM2 的 500M 模型已被整合到 iPhone 應用中,用戶可以直接在本地設備上分析視訊內容,無需依賴雲端運算。

2. VLC 媒體播放器集成

與 VLC 媒體播放器的合作,實現了智慧視訊片段描述和語義搜尋功能,用戶可以根據自然語言描述直接跳轉到影片中的相關部分。

3. 影片精彩片段產生器

這個應用程式可以從長達數小時的影片中自動提取最重要的時刻,適用於足球比賽等長時間的活動摘要。

與 Transformers 和 MLX 的結合

SmolVLM2 與 Hugging Face 的 Transformers 框架無縫集成,支持多種推理場景:

- 影片推理:用戶可以通過簡單的聊天模板,讓模型生成對影片的詳細描述。

- 多幅圖像推理:支援對多張圖片進行對比分析。

- MLX 支持:在 Apple Silicon 裝置上運行 SmolVLM2 的高效推理,適合 Swift 開發者。

此外,SmolVL

SmolVLM2:將視訊理解帶入每台設備

隨著人工智慧技術的快速發展,視訊理解模型正變得越來越重要。Hugging Face 推出的 SmolVLM2 系列,憑藉其高效能與小型化設計,為視訊理解樹立了新標杆。本文將帶你快速了解 SmolVLM2 的核心技術、應用場景及其在視訊理解領域的突破。

SmolVLM2 的願景與目標

SmolVLM2 的使命是將視訊理解的能力帶到每一台設備,無論是手機還是伺服器。與傳統需要大量計算資源的大型模型不同,SmolVLM2 將高效模型與小型化設計結合,實現了低資源環境下的高效視訊處理。

目前,SmolVLM2 提供三種不同規模的模型:

- 2.2B 模型:專為高效視訊和圖像理解而設計,是整個系列的旗艦。

- 500M 模型:在小型化與效能之間取得良好平衡。

- 256M 模型:實驗性質的極小型模型,探索小型模型的極限。

這些模型均可通過 Python 和 Swift API 使用,並且支持 Hugging Face 的 Transformers 框架。

核心技術與性能

SmolVLM2 2.2B:視覺與視訊的領先模型

2.2B 模型在多項基準測試中表現卓越,特別是在 Video-MME 基準上超越了所有現有的 2B 模型。該模型能夠:

- 解決圖像中的數學問題。

- 讀取照片中的文字。

- 理解複雜圖表及科學視覺問題。

其記憶體效率極高,甚至可以在免費的 Google Colab 環境中運行。

更小巧的 500M 和 256M 模型

- 500M 模型 提供了接近 2.2B 的視訊理解能力,但參數量僅為後者的四分之一。

- 256M 模型 則是一個實驗性版本,旨在探索小型模型的應用潛力,適合創新應用和專門的微調項目。

應用場景:SmolVLM2 的多功能演示套件

為了展示 SmolVLM2 的多樣化應用,Hugging Face 開發了多個演示應用程式:

1. iPhone 影片理解

SmolVLM2 的 500M 模型已被整合到 iPhone 應用中,用戶可以直接在本地設備上分析視訊內容,無需依賴雲端運算。

2. VLC 媒體播放器集成

與 VLC 媒體播放器的合作,實現了智慧視訊片段描述和語義搜尋功能,用戶可以根據自然語言描述直接跳轉到影片中的相關部分。

3. 影片精彩片段產生器

這個應用程式可以從長達數小時的影片中自動提取最重要的時刻,適用於足球比賽等長時間的活動摘要。

與 Transformers 和 MLX 的結合

SmolVLM2 與 Hugging Face 的 Transformers 框架無縫集成,支持多種推理場景:

- 影片推理:用戶可以通過簡單的聊天模板,讓模型生成對影片的詳細描述。

- 多幅圖像推理:支援對多張圖片進行對比分析。

- MLX 支持:在 Apple Silicon 裝置上運行 SmolVLM2 的高效推理,適合 Swift 開發者。

此外,SmolVLM2 還支持在視訊數據上的微調,用戶可以根據自己的需求進一步優化模型。

為未來創造更多可能

SmolVLM2 的推出標誌著視訊理解模型進入了一個新時代。它不僅在效能上實現了突破,還通過小型化設計使模型更加普及,適用於更多場景和設備。

如果你對 SmolVLM2 感興趣,歡迎探索以下資源:

M2 還支持在視訊數據上的微調,用戶可以根據自己的需求進一步優化模型。

為未來創造更多可能

SmolVLM2 的推出標誌著視訊理解模型進入了一個新時代。它不僅在效能上實現了突破,還通過小型化設計使模型更加普及,適用於更多場景和設備。

如果你對 SmolVLM2 感興趣,歡迎探索以下資源: